AI 之父 Jürgen Schmidhuber 眼中的深度学习十年,以及下一个十年展望

AI 之父 Jürgen Schmidhuber 眼中的深度学习十年,以及下一个十年展望2020 年是充满科幻的一年,曾经我们畅想飞行汽车、智能洗碗机器人以及能自动写代码的程序,然

2020 年是充满科幻的一年,曾经我们畅想飞行汽车、智能洗碗机器人以及能自动写代码的程序,然而这一切都没有发生。

2020 迎接我们的是澳洲大火、新冠病毒和漫天的蝗虫。回想过去的十年,我们或许觉得没有什么科技的发展可以称得上是飞跃,然而事实却是,一切都变了,深度学习算法的进步和影响就是起哄最明显的标志。

AI 之父 Jürgen Schmidhuber 在自己的 Medium 专栏发布了一篇文章,回顾了深度学习的十年发展历程,回头看看,才发现我们确实见证了历史。

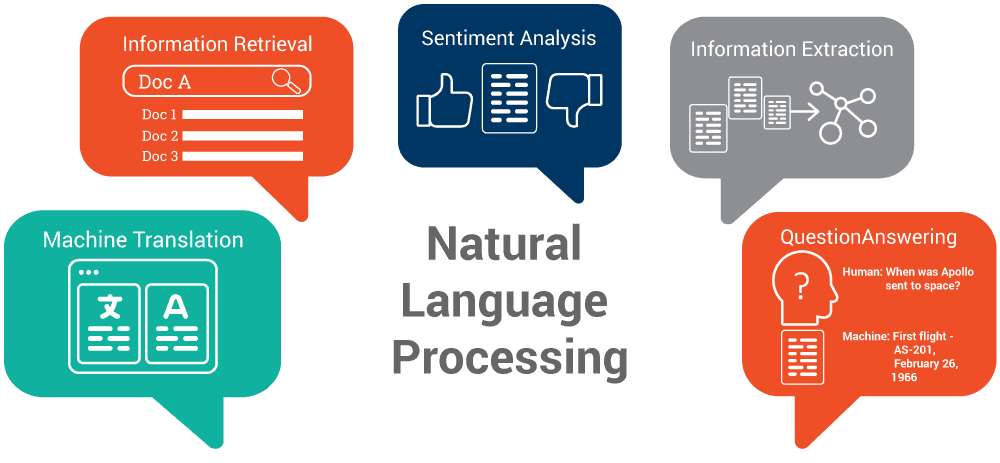

自然语言处理

尽管不像深度学习中的其他领域那么高大上,但可以说 NLP 算法是迄今为止最复杂、最成功的算法。这种成功可以归因于,与图像和视频相比,在文本语料库上进行训练相对比较容易。在过去的十年中,NLP 不仅取得了巨大进步,而且还成功地成为了各种商业应用中的重要组成部分。正如你将在下文中注意到的那样,Google 的研究人员在改善 NLP 算法方面发挥了最重要的作用,不过实话说,几乎所有全球研究实验室都为这一领域的发展做出了贡献。

图片:Ontotext

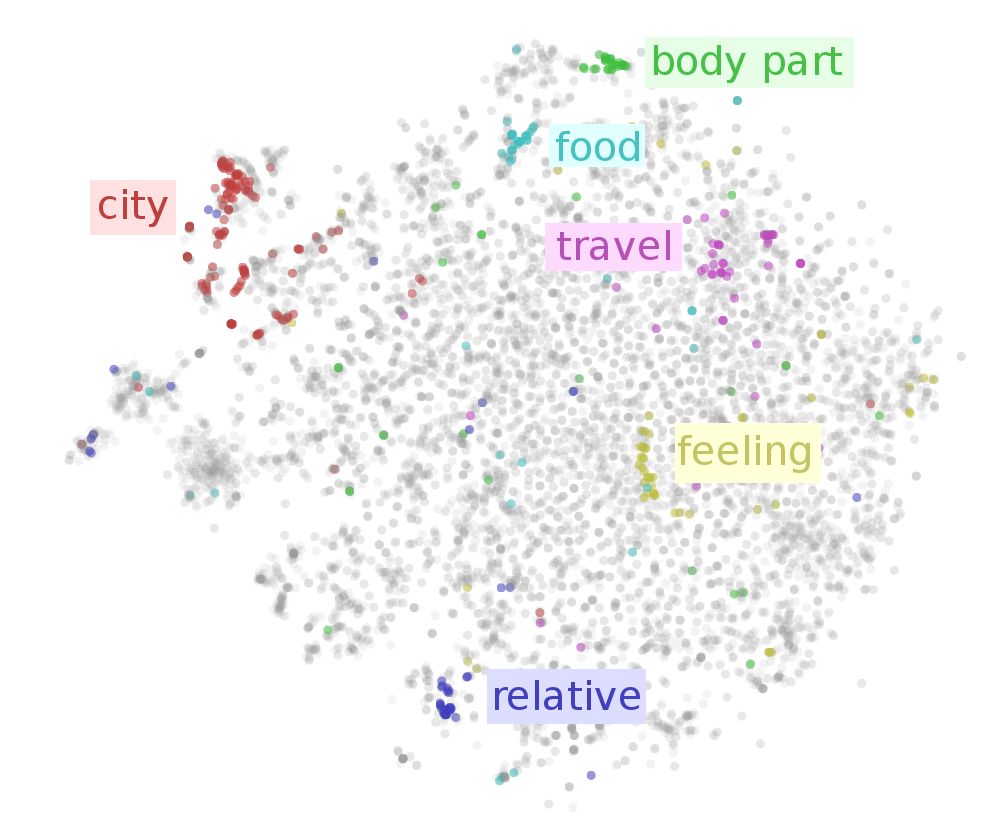

01词嵌入

在技术上也称为分布语义模型,如今,几乎所有 NLP 算法中都有使用词嵌入。Bengio 等人早在 2003 年就提出将词嵌入为向量这一方法。它仍然非常耗费计算资源,并且需要更有效的算法来实现。2013 年,Google 提出了“连续词袋模型”(Continuous Bag-of-Words Model, CBOW)和“连续 Skpi-gram”模型,并使用 word2vec 以计算并实现开源,使得词嵌入技术得到广泛应用。在 2015 年,斯坦福大学的研究人员介绍了 GloVe 模型,该模型对词嵌入算法进行了进一步改进。

图片:Sebastian Ruder

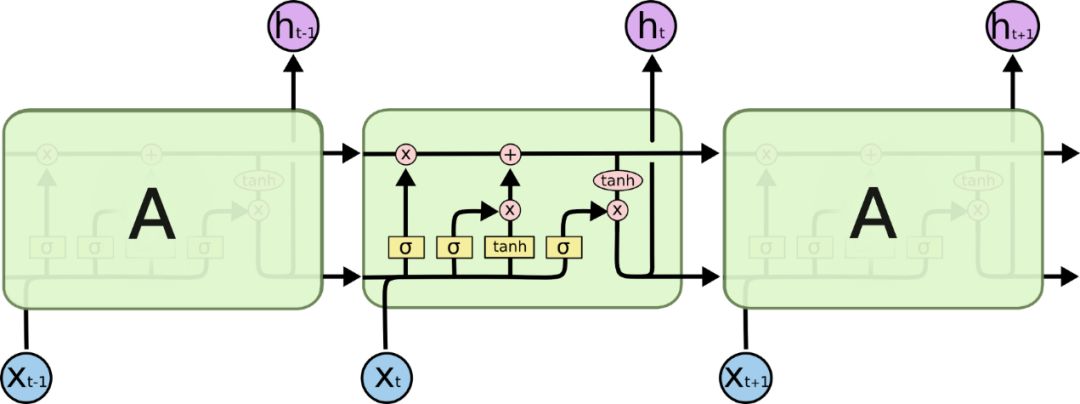

02LSTM 算法

图片:Christopher Olah

虽然 LSTM 最初是由 Hochreiter 和 Schmidhuber 早在 1997 年提出的,但在这过去的十年中,它们才真正地受到关注。尽管许多较新的算法在性能上比 LSTM 表现更好,但它们在一些商业上成功的翻译软件(例如Google Translate)和 Apple 的 Siri 中仍然发挥着重要作用。Cho Kyunghyun Cho 等研究人员通过提出门控循环单元(GRU),为 LSTM 体系结构提供了进一步的改进。GRU 自然会引导我们进行下一个创新……

03Seq2Seq 模型

来自 Google 的 Sutskever 等人在 2014 年推出了现在流行的 Seq2Seq 模型。在先前 RNN、LSTM 和 GRU 相关工作的基础上,这种嵌入解码技术为 Google Translate 和许多其他 NLP 任务赋能。在易于实现的同时,这一技术甚至可以用来创建聊天机器人。

04Transformers

Google Brain 那篇“ 你只需要注意力就够了”(Attention is All You Need)论文可是引起了一场轰动。通过将焦点仅集中在数据的重要组成部分上,这样的注意力可以提供比 LSTM 更优秀的表现,并且所需的计算量也更小。

05BERT

图片:YNG Media

在十年结束之前,谷歌再次在 NLP 方面取得了突破:BERT 模型。它是一种可同时从左向右以及从右向左考虑文本的语言表示模型。虽然可以说谷歌研究人员的确有助力于公司平台无与伦比的处理能力而在多项 NLP 任务中达到了最先进的水平,模型本身也真的是非常灵活多变。经过预训练的 BERT 模型可以通过简单添加额外的输出层来适应几乎任何任务。

06语音助手

图片:Business Insider / Yu Han

2011 年 10 月发布的 iPhone 4S 是第一款集成 Siri 的苹果产品。这在智能手机领域是革命性的,因为这是首次向大众商业市场提供与未来人工智能密切相关的技术。目前市场上充满了语音助手,它们在诸如语音识别、语音转文本、文本翻译等一系列任务上的表现都非常出色。想要知道这一技术有多么普遍的话,你可以随便走入任何一家稍微与科技接轨的家庭,喊出“ Alexa!”——您很可能会听到熟悉的声音回复呢。

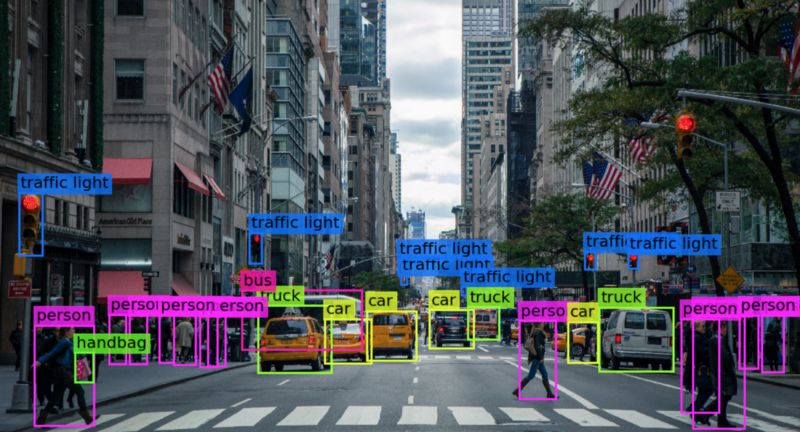

计算机视觉

图片:Ilija Mihajlovic

人工智能是人工智能领域中最令人兴奋和研究最多的领域之一。从进化型自动驾驶汽车到已成为智能手机常见功能的人脸识别,计算机视觉无处不在。尽管这十年来主要是研究实验室希望挑战计算机视觉任务的最新结果,我们仍然严重依赖于数据数量和机器处理能力。

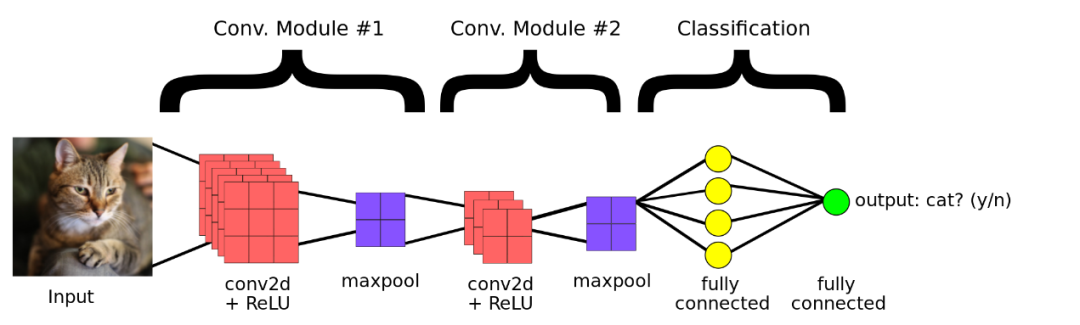

01CNN

图片:Google

福岛在 1980 年提出了第一个深度神经网络,随后是 Yann LeCun 发明的我们今天所知的卷积神经网络(LeNet)。但是,尽管 CNN 已出现了很多年,它们似乎仅仅在最近十年中才进入主流视野。

现在是计算机视觉任务的标准化基准的 ImageNet 于 2010 年才开始年度竞赛。2012 年,来自多伦多大学的 Krizhevsky 等人在此项竞赛中提出了 AlexNet,它大大击败了 ImageNet 中的现有算法。这为接下来的十年中激烈竞争设计最佳 CNN 的各大实验室奠定了技术基础。

在接下来的几年中,我们看到了几种著名的 CNN 变体,例如 VGG 神经网络、提出更深的网络性能更好的 Inception,以及甚至更深层的残差学习框架 ResNet。尽管 CNN 架构的发展一直在快速发展,但最近的重点已经转移到了鲁棒性和效率而非仅仅是准确性上。大众对未来的希望是将这些高性能的 CNN 引入商业应用。

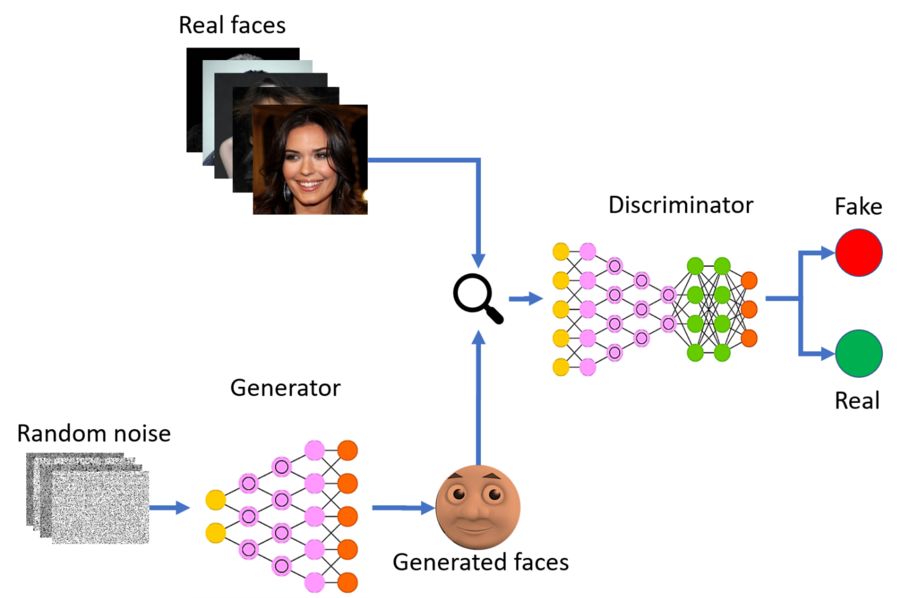

02全能的 GANs

图片:Sarvasv Kulpati/Sigmoid

自 2014 年 Goodfellow 提出了 GANs(Generative Adversarial Networks,生成对抗网络),它现在已成为深度神经网络领域最新和最成功的突破之一。它开辟了 AI 的全新应用领域,而且我认为它代表了深度学习中最直观的架构之一。

时至今日,GANs 在研究界非常流行,以至于你能发现各种名称的 GANs。他们使用 X-GAN 规则命名,其中 X 代表你给自己的 GAN 所取的有趣的名字。这对他们的实用性丝毫无损,GANs 已被发现在多种任务中都表现出色。只有时间能够证明,是否它的发现标志着 AI 演进中的一个重要里程碑。

03AI 的艺术

图片:Christie’s

由 GANs 和类似深度学习模型的成功所推动,AI 进入了一个新方向,它模糊了真实的与 AI 生成的输出之间的界限。我们现在拥有的 AI,可以为你描绘一幅美丽的艺术品,能创作和演奏歌曲,能生成文字故事,还能人工模拟很多事情。对于这些 deepfakes,大家显然有担忧;但也有一些人开始慢慢接受这种新的艺术潮流进入我们的文化。2018 年 12 月 12 日,佳士得拍卖了一副 AI 创作的肖像画,拍卖价格高达 432500 美元!

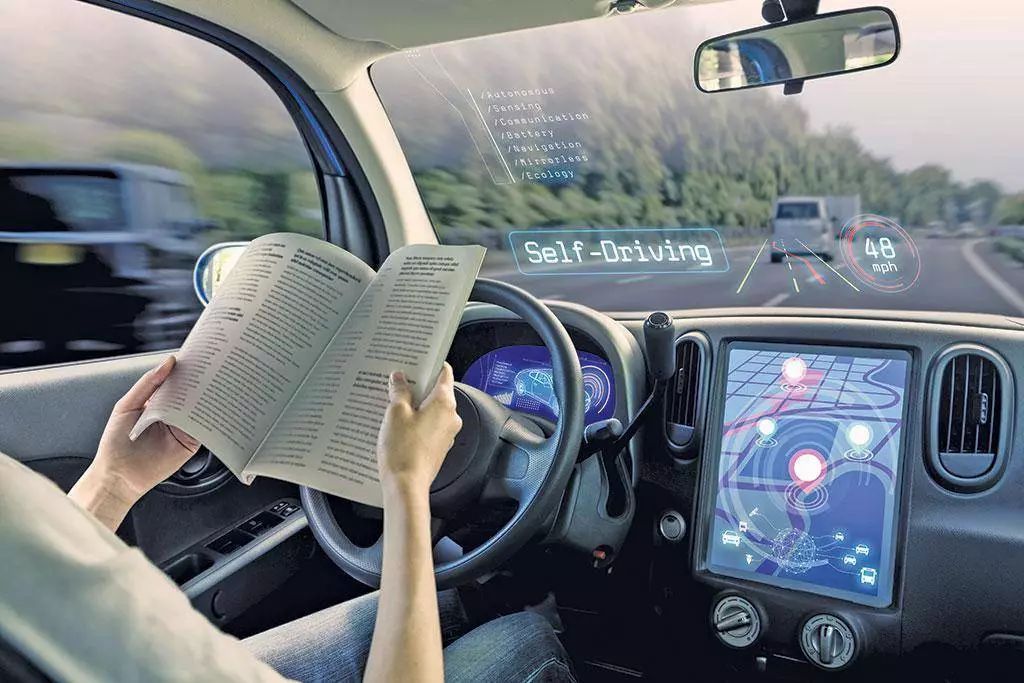

04自动驾驶汽车

图片:DownToEarth

不论你是否支持,它将最终发生,任何事情都无法阻止我们日常生活中的这个巨大改变。在 21 世纪的前 10 年,自动驾驶汽车已变成商业现实,所有主要的技术和汽车公司都为此投入巨资。虽然自动驾驶汽车没成为这 10 年的重大革命,但他们已经奠定了坚实的基础,并在下个 10 年大发展。如果你想了解这对我们意味着什么,可以查阅我们关于 AI 伦理的文章:自动驾驶汽车。

强化学习

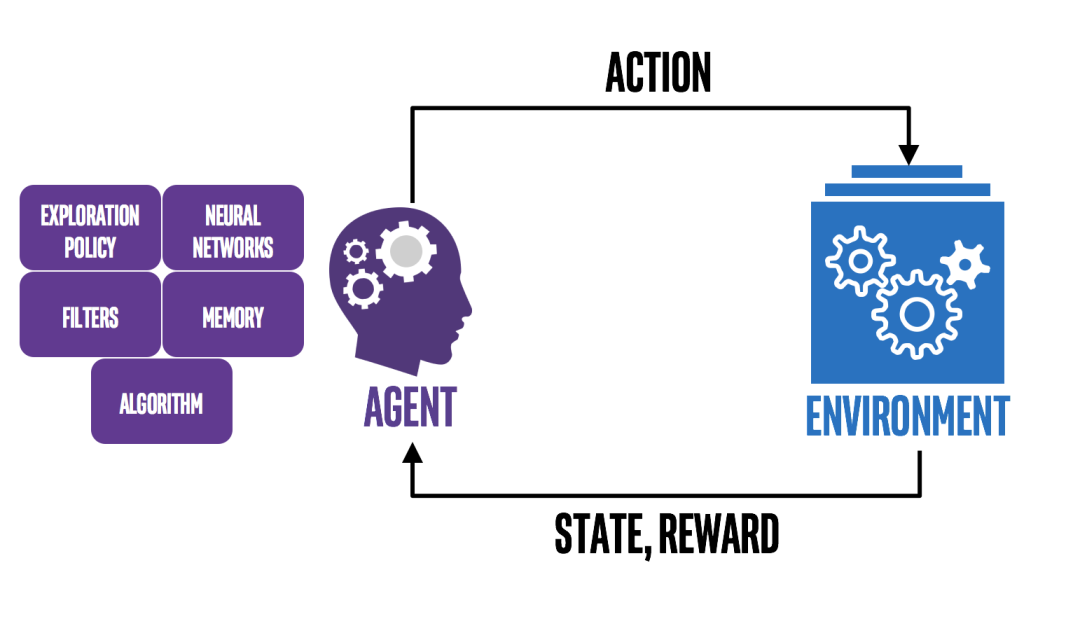

图片:Intel AI

强化学习是全功能机器人的核心,其目标就是设计出能像人一样,学会实现基于奖励的任务的 AI。不像本文讨论的其他领域,强化学习是完全无监督学习,模型缺乏事先可供学习的正确数据。模型要学会在奖励最大化的前提下,对可能的解决方案排序。对于这种新技术,研究界也花费了时间去采纳。但从这个世纪之初,强化学习就已经成为所有主要实验室深度学习研究的一个普遍组成部分。

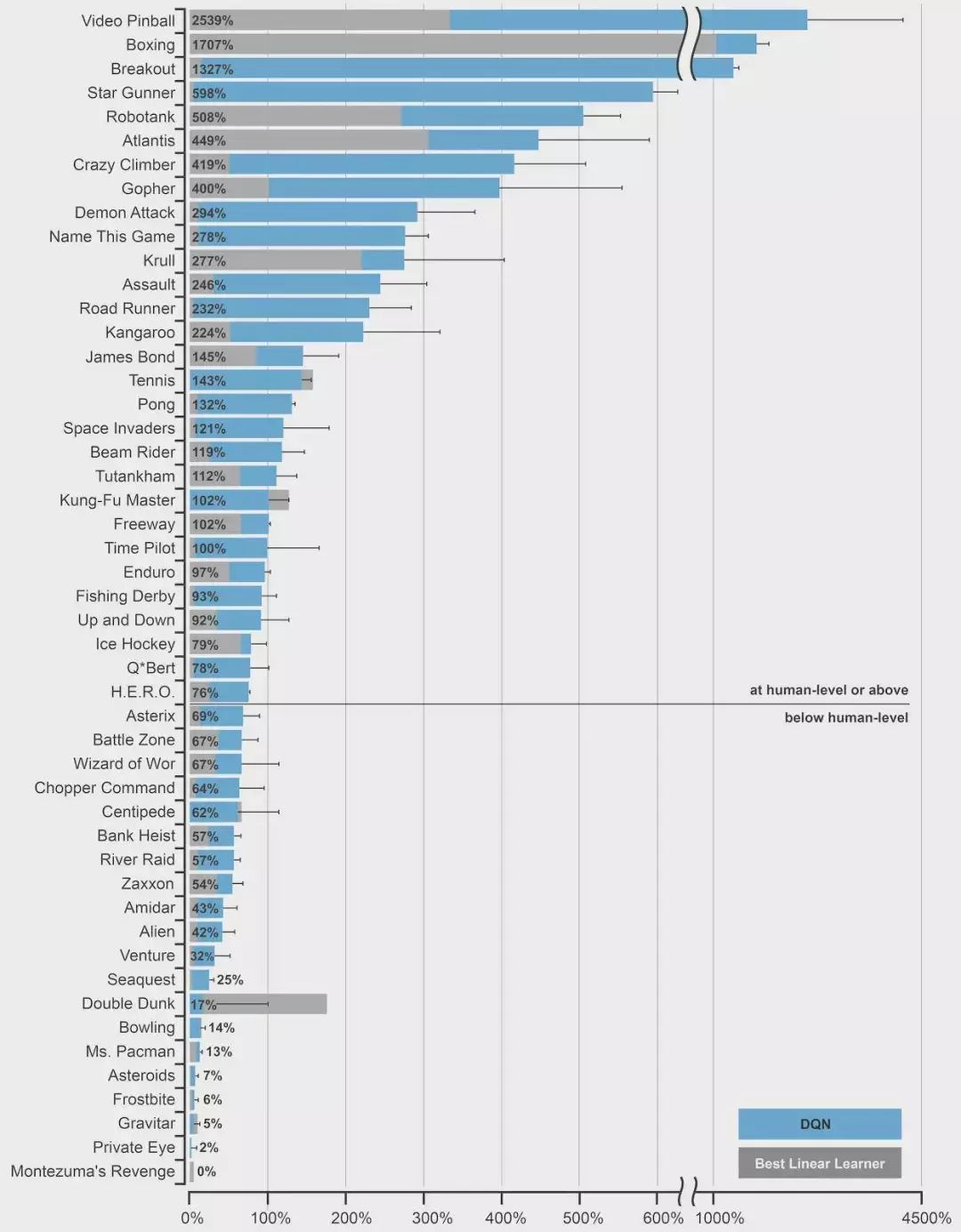

01玩 Atari 的 DQN

图片:DeepMind

DeepMind 将深度强化学习应用在 Atari 游戏环境中玩复杂游戏。深度学习模型成功击败人类游戏专家奠定了深度强化学习在 AI 研究领域的领先地位。来年,Google 收购了 DeepMind 实验室……

02AlphaGo 点亮新开端

是的,甚至有一部名为“AlphaGo Movie”的电影。

没有比 Google 的 DeepMind AlphaGo 打败职业围棋世界冠军更合适的例证,来说明这十年强化学习的普及。他们更进了一步,没有任何人类监督学习,AlphaGo Master 设法以 3-0 打败了世界排名第一的围棋选手。这个事件包揽了全球头条,并使 AI 算法普及成为主流。AI 目前能在复杂赛事最高级别竞赛中击败人类,这是非常了不起的成就。

03机器人

索菲亚并非我们所期望的机器人。图片:ELLE

强化学习模型最关键的应用是设计机器人。我们目前仍在等待能安全部署在家中实用的商用机器人。尽管机器人在持续改进,但他们作为实用工具(而非娱乐工具)尚不尽人意。机器人应用包括了机器人手术臂、太空探索机器人和工业机器人。设计各种各样实际工作的机器人,并确保它在任意环境中的性能,是项挑战。在监督环境中训练机器人的能力有明显瓶颈,因此,研究者们期待基于奖励的深度强化学习能成为一个解决方案。

下一个十年会怎样?

在见证了深度学习革命性的十年,我们确信接下来的十年应该令我们所有人兴奋。在这十年中,AI 将接手大部分的工作吗(通常的小报标题)?我们能够优化深度学习模型,从而在日常工作中持续使用吗?接下来的内容将会回答这些担心。

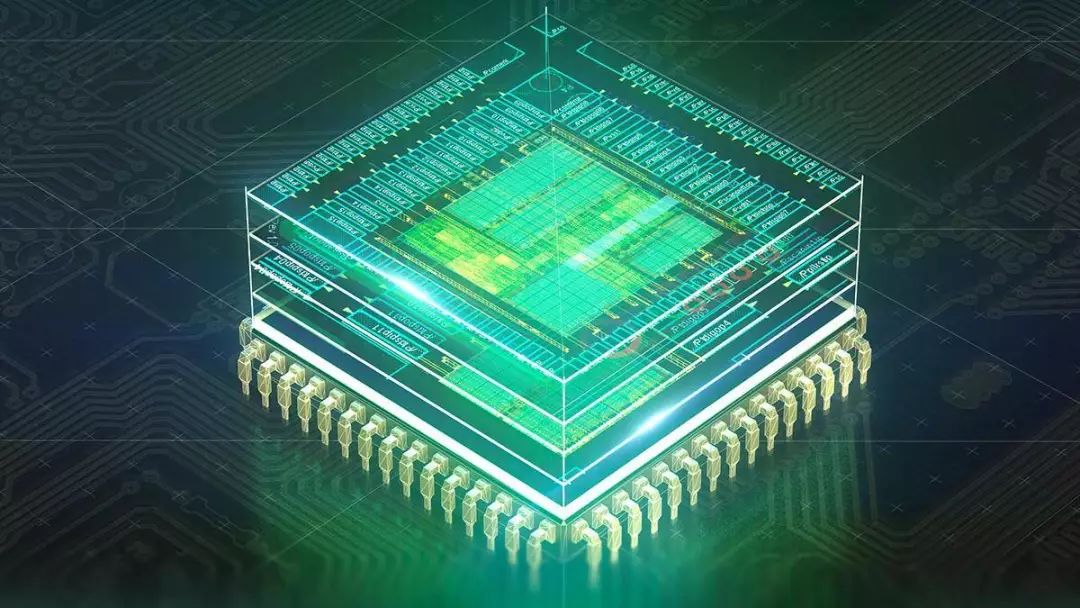

01量子计算

图片:Cisco

在过去十年里,物理学本身在探究量子力学方面取得了长足的进步,但我们即将见证一场技术上的巨大革命。量子计算的目标是利用量子迭加和纠缠原理,提供领先于我们现有系统数光年的计算能力。如果我们能够控制量子位,我们在 21 世纪 20 年代能完美见证这些量子计算机的威力。尽管对于它可能解密我们现在所有的安全算法存在担心,但每项革新,其优点都将远远超过它的缺点。

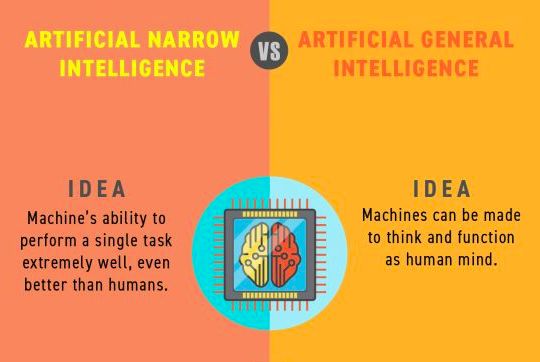

02无监督学习

图片:Analytics India Magazine

今天大多数深度学习模型都严重依赖于海量训练数据的可获取性。这个问题可能的解决方案是元学习和小样本学习。元学习算法的目的是通过有限任务的学习,学会如何执行大量的新任务。按照相似的思路,小样本学习算法是通过有限数量数据的学习来执行任务。两者都聚焦于有效表征的泛化。

03浅层学习网络

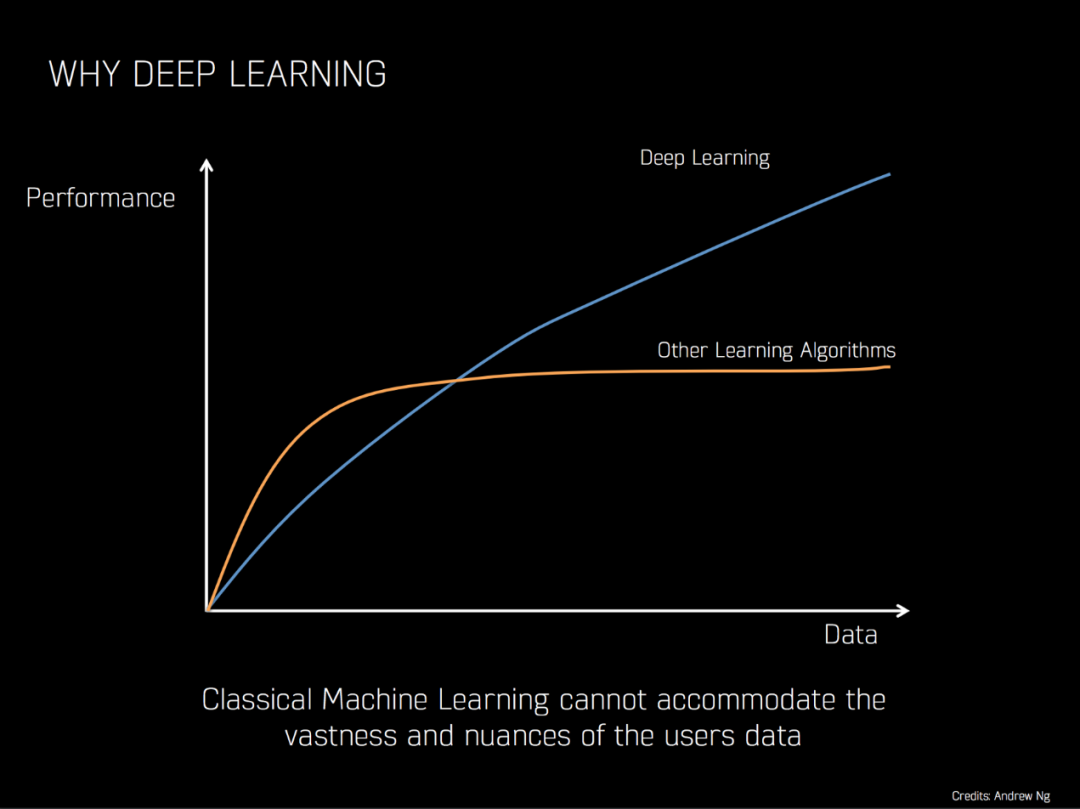

图片:Andrew Ng

更深入会是前进的方向吗?不一定,因为越来越多的研究者正在寻找深度学习模型的替代方案。深度模型需要更多的计算和更多的数据。虽然深度学习毋庸置疑是这十年的明星,但这十年也是一个好时机,可以使深度学习能很快被浓缩为提供相似或更好性能的更紧凑、可扩展的模型。

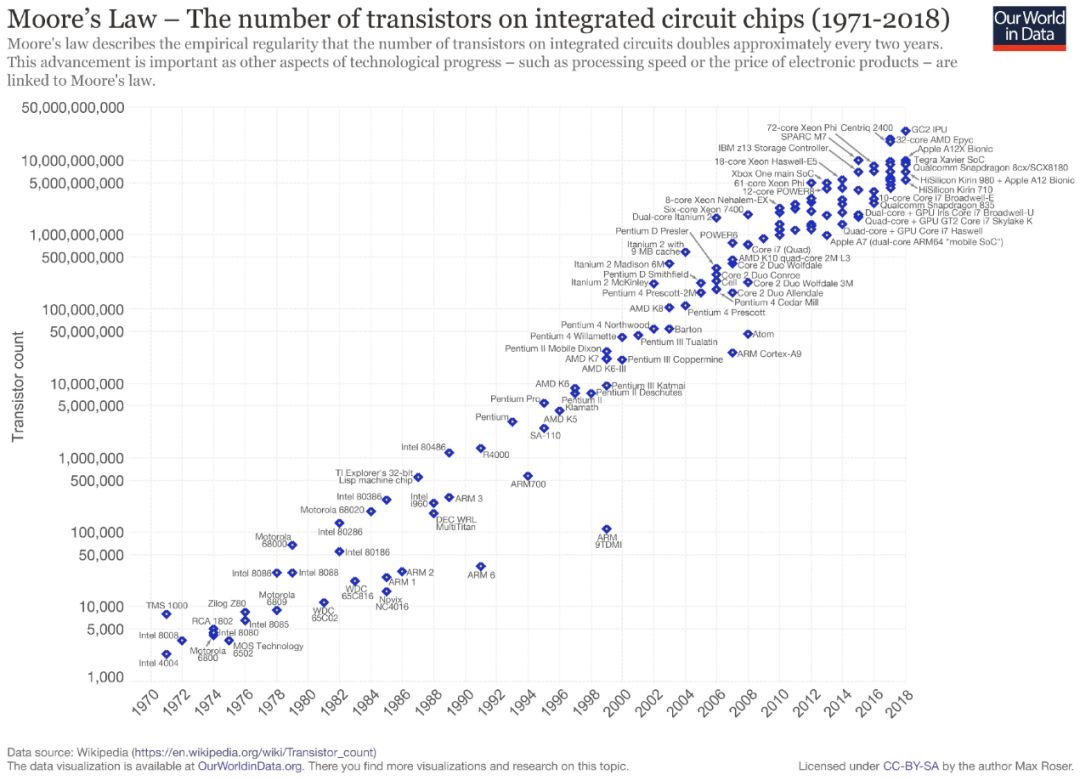

04算力 vs 深度学习进展

摩尔定律观察发现,集成电路上元器件数量大约每隔 2 年翻一番。自 1975 年摩尔定律提出以来一直颠扑不破,但近 10 年来我们的发展慢了下来。因此,很多人相信技术进步即将到来,很可能就是我们前文讨论的量子计算。这将有助于推动深度学习的重大进步。

作者 | Jürgen Schmidhuber 编译 | 张秋玥、马莉

-

大众持续噩梦2020-03-05

-

一文读懂即将引爆的TinyML:在边缘侧实现超低功耗机器学习2020-03-05

-

未来十年最火的人工智能,你知道去哪里留学最实用吗?2020-03-05

-

受新冠状病毒冲击 现代汽车2月全球销量创十年来新低2020-03-05

-

德国检方扩大对保时捷“排放门”丑闻调查,大众累计代价超300亿欧元2020-03-04

-

致敬经典,大众发布第8代高尔夫GTI及Touareg R2020-03-04

-

“大象转身”背后:大众集团拟100%控股奥迪品牌,意欲何为?2020-03-03

-

大众汽车公布年度业绩报告:中国市场利润达340亿元2020-03-02

-

买断最后流通股份 奥迪要被大众完全收入囊中2020-03-02

-

大众就“排放门”与德国消费者达成和解:一次性赔偿8.3亿欧元2020-03-02

-

大众Polo三厢掀背版车型官图发布:酷似桑塔纳 今年俄罗斯投产上市2020-02-26

-

亮相日内瓦车展,大众第8代Golf GTI有何亮点?2020-02-25

-

对标特斯拉第二代Roadster?大众或推出基于MEB平台的ID.R纯电动跑车2020-02-25

-

大众集团1月全球销量83.7万辆:中国地区同比下滑11.3%2020-02-24

-

本田中国人事大调整!十年老兵将离任2020-02-22