加州大学洛杉矶分校研究团队发明可解释性AI,人机信任危机有望得到解决

加州大学洛杉矶分校研究团队发明可解释性AI,人机信任危机有望得到解决From: Fast Company; 作者:Iris人工智能正以多种方式进入我们的生活——手机智能助手帮助我们

From: Fast Company; 作者:Iris

人工智能正以多种方式进入我们的生活——手机智能助手帮助我们完成一系列基础任务,智能家电能自动打扫我们的房屋,地图导航指挥着我们该驶向何方。随着AI在日常生活中的重要性逐渐提高,关于人与机器之间的信任危机的问题又进入了大众的视野:我们能信任它们吗?我们怎么知道它们会准确地听从指令并执行任务?

可解释性AI(XAI)是人工智能研究的一个分支,它的关注点在于如何提升人工智能之于人类的可信任度。要实现机器人和人一起和谐工作的愿景,可信度发挥着至关重要的作用。XAI便致力于开发让人类感觉值得信赖的人工智能系统,以促进它们更好地融入人类社会。

从开瓶盖入手

浅谈机器人自我解释能力

加州大学洛杉矶分校的研究团队尝试让机器人向人类用户解释它的行动的内容和目标,并证明这么做是有效的。有趣的是,可信赖度最高的智能自我解释形式,与性能最佳的学习算法并不对应。可见,机器人的性能和自我解释的能力并不相同——我们不能只单独优化它的性能或自我解释的能力。这要求在设计机器人的过程中既要考虑良好的性能,又要考虑到可信赖度高的自我解释形式。

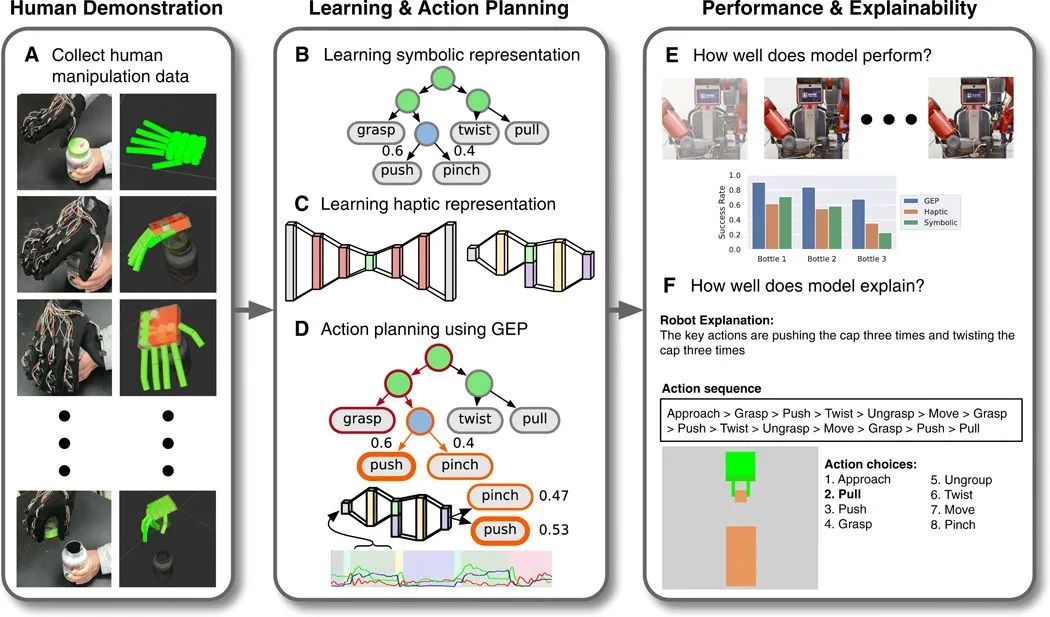

用户演示、机器学习、任务表现和解释能力的关系图

机器人如何才能做到最高效率地执行用户指定的任务?用户又应如何回应机器人的自我解释行为呢?

为了回答这两个问题,团队决定做一个实验,他们尝试让机器人学习如何拧开药瓶的瓶盖。实验中,一个研究人员戴着一个有触觉记忆系统的手套,当他打开瓶子时,手套会记录下人手的姿势和力量。这能帮助机器人通过象征性信息和触觉信息来了解人类的行为。象征性信息是指有意义的行为动作,比如抓取的动作。触觉信息指的是与身体姿势和动作相关的感觉,例如手指合拢的感觉信息。

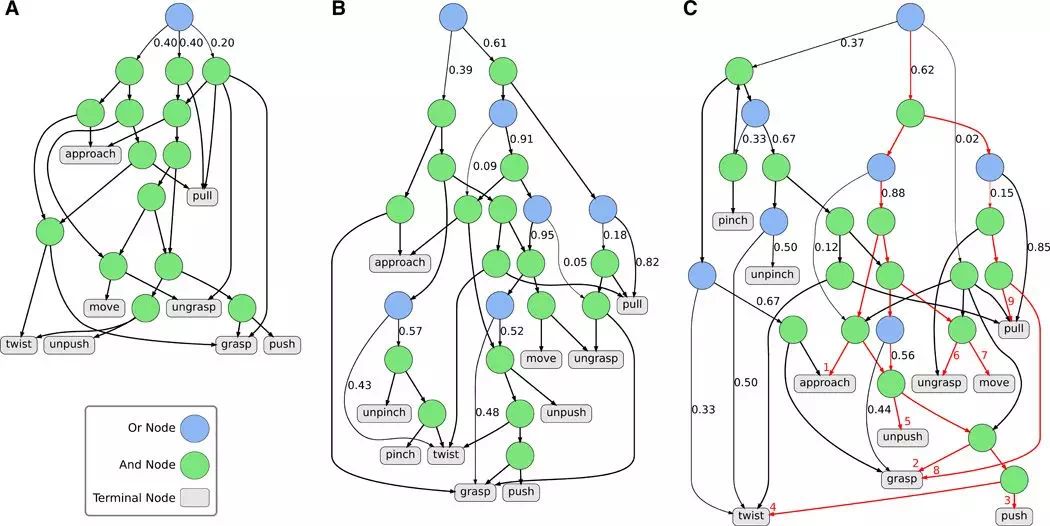

总结出的象征性信息(中间)和触觉模型(底部)为机器人的动作提供解释文本

机器人在吸收了象征性信息后,会对完成打开瓶子的任务所需的步骤序列进行编码。在接触触觉信息后,机器人将形成一种触觉模型,该模型帮助机器人“想象”着自己处于人类用户的视角,并试着预测人类在这种场合会采取什么行动。

事实证明,当把象征性信息和触觉信息结合在一起输入系统时,机器人能够达到自身的最佳性能。与单独分开输入这两种信息相比,同时获得这两种信息的机器人在依照步骤来执行任务和通过夹持器进行实时感知方面表现得更好。也就是说,要让机器人高效率地执行任务,共同输入这两项信息是必不可少的。

象征性信息的总结和语法符号推导过程示意图

既然机器人能够理解自己要做的任务,它又该怎么向人类用户解释它的行为呢?这种自我解释真的能促进人类对机器人的信任吗?

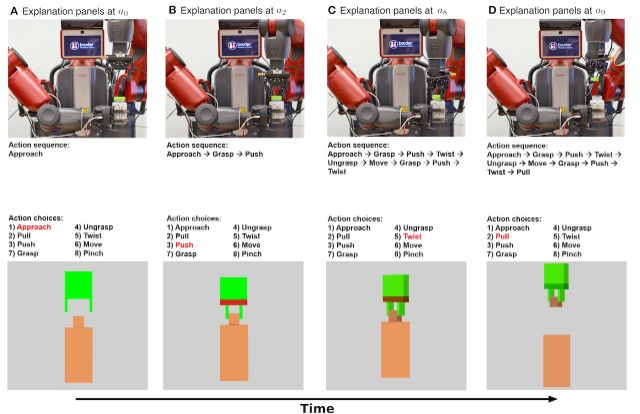

在实验中,团队为人类添加了自我解释的流程:在机器人完成打开药瓶的任务后,它需用文本记录的形式提供了一个任务执行总结。团队邀请了150名参与者,分成五组,观察机器人执行打开药瓶的任务的过程。

任务完成后,机器人给其中四组提供不同的任务解释——基于象征性信息的解释文本能详细说明每个步骤的动作内容,基于触觉信息的解释文本则着重于说明机械手臂夹持的位置和姿势,总结性的解释文本则将象征性信息和触觉信息结合在一起,而第五组的参与者只能观看机器人开瓶子的视频,没有得到任何文本反馈。

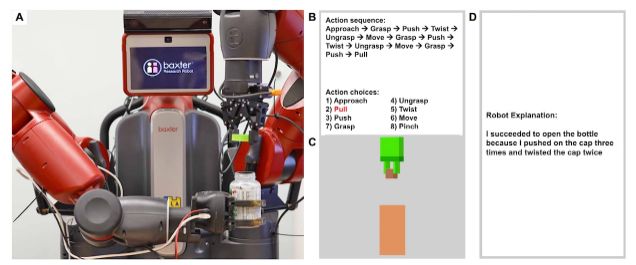

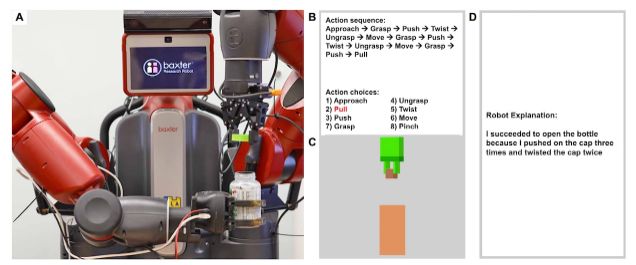

A)解释面板实物;B)象征性解释文本;C)触觉说明文本;D)文字说明总结

团队发现,同时提供象征性和触觉信息的文本解释最能培养机器人与人类之间的信任。有趣的是,完全基于触觉信息的解释文本在增强人机之间的信赖感方面并无贡献,这表明人类更喜欢机器人逐步解释它们工作的内容。

为人机关系的未来而勉励前行

这项研究最有趣的结果是,机器人的良好性能与让它们博取人类信任的因素是完全不同的。这也突显了未来人工智能和机器人研究领域的重要目标:专注于追求机器性能和自我解释能力,而不厚己薄彼。

性能和自我解释能力并非两个可以实现互补的因素,因此在构建AI系统时,两者都是需要着重考虑的首要目标。这项工作也是系统研究人机关系发展前景的关键环节,若研究人员能从中得出具有突破性的成就,那么,未来研究中更具挑战性的一环将是从“我相信机器人做X”到“我相信机器人”。

机器人要想在人们的日常生活中占有一席之地,必须先获得人类的信任。了解机器人如何提供有助于增进人类的信赖度的自我解释文本,是使人类和机器人能够共同工作、和睦相处的重要一步。

-

加州大学洛杉矶分校研究团队发明会自我解释的机器人2020-03-11

-

机器人任意曲线轨迹规划基础——样条曲线2020-03-11

-

抗疫战场,浙江移动智能机器人战队逆流而上2020-03-11

-

扫地机器人十大必买品牌排行榜 被大众认可的牌子哪个好?2020-03-11

-

泉州酒店救出59人:让机器人助守生命防线2020-03-10

-

深耕数字化、电动化,大众汽车新品发布背后几大信号2020-03-10

-

DeepTalk深言堂 | 清华孙富春:面向灵巧操作的机器人主动感知与认知学习2020-03-10

-

海康机器人吴永海:移动机器人,2020年市场规模预计达70亿元2020-03-10

-

移动机器人,2020年市场规模预计达70亿元2020-03-10

-

钟南山团队联合研发咽拭子智能采样机器人取得阶段性进展2020-03-10

-

石头科技上市:巨头瓜分后的清洁机器人市场如何发展?|睿兽分析2020-03-10

-

从VR游戏到有血液系统的机器人,培养一个医生需要多少“黑科技”?2020-03-10

-

无人机霸主跨界教育机器人:它比蓝翔好玩多了2020-03-09

-

专注于机器人制造,卡诺普获近亿人民币B轮融资2020-03-09

-

新冠疫情对机器人市场影响及2020年展望2020-03-09